Kommende iOS-Beta bringt Deep Fusion aufs iPhone 11

Apple wird in Kürze die erste Beta veröffentlichen, vermutlich iOS 13.2, die eine Funktion einführen wird die Apple auf der Keynote zum iPhone 11 und iPhone 11 Pro kurz vorgestellt hatte: Deep Fusion.

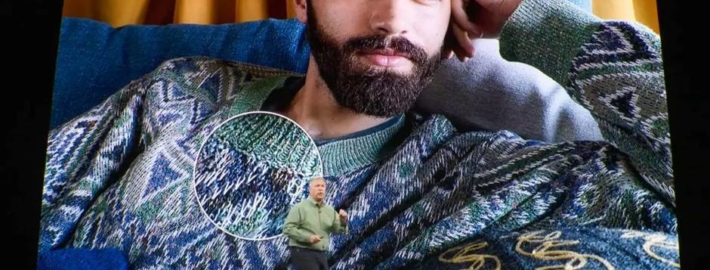

Deep Fusion ist ein neues Bildverarbeitungssystem, das die A13 Bionic und die Neural Engine nutzt. Deep Fusion nutzt die Vorteile von maschinellen Lerntechniken, um Fotos Pixel für Pixel zu bearbeiten und optimiert Texturen, Details und Rauschen in jedem Teil des Bildes.

Diese Funktion zielt auf die Verbesserung von Innenaufnahmen und Fotos, die bei mittlerer Beleuchtung aufgenommen wurden, und sie wird automatisch aktiviert, je nachdem, welche Linse verwendet wird und wie hell das Licht im Raum ist. Das Weitwinkelobjektiv verwendet standardmäßig Smart HDR für helle Szenen, wobei Deep Fusion im mittleren oder schwachen Licht und der Night Mode für dunklere Szenen aktiviert wird.

Das Teleobjektiv verwendet hauptsächlich Deep Fusion, aber wenn die Beleuchtung sehr hell ist wird stattdessen Smart HDR aktiviert. Der Nachtmodus wird aktiviert, wenn die Beleuchtung zu dunkel ist. Das Ultra-Weitwinkelobjektiv verwendet nur Smart HDR und unterstützt kein Deep Fusion (und keinen Nachtmodus).

The Verge hat einen Einblick darüber veröffentlicht, wie Deep Fusion funktioniert, zusammen mit Informationen die von Apple stammen. Deep Fusion läuft komplett im Hintergrund, und im Gegensatz zum Nachtmodus gibt es keine Möglichkeit, es ein- oder auszuschalten.

Deep Fusion ist ein komplexer Prozess, bei dem die Hardware im iPhone mehrere Aktionen ausführt, wenn ein Foto aufgenommen wird. Bereits bevor der Auslöser gedrückt wird nimmt die Kamera drei Bilder mit einer kurzen Verschlusszeit auf, um die Bewegung einzufrieren. Wenn dann der Auslöser gedrückt wird werden drei weitere Fotos aufgenommen, und dann wird ein länger belichtetes Foto gemacht, um mehr Details zu erhalten.

Die drei regulären Fotos und die Langzeitaufnahme werden zu dem verschmolzen, was Apple als „synthetic long“ bezeichnet, was sich vom Smart HDR unterscheidet. Deep Fusion wählt das detailreichste Kurzzeitbelichtungsbild aus und führt es dann mit der synthetischen Langzeitbelichtung zusammen (es sind also nur zwei Bilder, die zusammengeführt werden).

Die Bilder werden dann in vier Schritten, Pixel für Pixel, verarbeitet, um die Details zu erhöhen und dem A13-Chip Anweisungen zu geben, wie die beiden Bilder miteinander vermischt werden sollen. – Himmel und Wände befinden sich im untersten Bereich, während Haut, Haare, Stoffe und so weiter auf höchstem Niveau liegen. Dies erzeugt eine Reihe von Gewichtungen für die Mischung der beiden Bilder – Detailaufnahmen von dem einen Bild, während weitere Details, Ton, Farbe, Helligkeit und mehr von der anderen Aufnahme genommen werden.

Die Aufnahme einer Deep Fusion-Aufnahme dauert etwas länger als die eines normalen Smart HDR-Bildes – etwa eine Sekunde – so dass Apple zunächst ein Vorschaubild anzeigt, wenn man direkt nach der Aufnahme einer Deep Fusion-Aufnahme in die Fotoapp schaut.

Phil Schiller beschrieb Deep Fusion als „computational photography mad science“, als sie letzten Monat erstmals vorgestellt wurde. Während bereits die normalen Aufnahmen der Kameras iPhone 11 und iPhone 11 Pro relativ beeindruckend sind, hat Deep Fusion laut „The Verge“ das Potenzial, die Fotografie auf die nächste Stufe zu heben.

Es gibt keine konkreten Details darüber, wann iOS 13.2 (und vermutlich iPadOS 13.2) kommen werden, aber das Update könnte jederzeit veröffentlicht werden.